La ética en el desarrollo de sistemas de inteligencia artificial debe estar presente en todos los ámbitos de su uso.

Con el avance de esta tecnología, surgen importantes consideraciones sobre sus implicaciones sociales y los principios que deben guiar su creación.

Los dilemas éticos se han vuelto cada vez más complejos, afectando a múltiples sectores. Es necesario establecer marcos que aseguren la responsabilidad, la transparencia y el respeto por los derechos humanos en el uso de la inteligencia artificial.

Los dilemas éticos en el ámbito de la IA surgen en diversas situaciones donde los valores pueden entrar en conflicto. Es esencial abordar cuestiones como:

- La responsabilidad por las decisiones tomadas por sistemas autónomos.

- Los sesgos presentes en los algoritmos y su influencia en la justicia social.

- La privacidad de los datos y el consentimiento informado de los usuarios.

- El impacto en el empleo y la economía, considerando la automatización de trabajos.

Comprender estos dilemas exige un enfoque multidisciplinario que incluya la ética, la filosofía, la sociología y la tecnología misma.

Los retos éticos no están limitados a las fases iniciales de desarrollo de la IA. Hay que tener en cuenta los desafíos en cada etapa del ciclo de vida, que incluyen:

- El diseño de algoritmos responsables que minimicen sesgos y promuevan la equidad.

- La implementación de medidas que aseguren la seguridad y privacidad desde el diseño.

- La evaluación continua de los sistema para detectar posibles brechas éticas.

- La gestión de actualizaciones y cambios en los sistemas de IA y el impacto que estos puedan tener.

El proceso completo requiere la integración de principios éticos para garantizar que la inteligencia artificial beneficie a la sociedad de manera justa y equitativa.

Principios éticos para los sistemas de inteligencia artificial

El establecimiento de principios éticos es esencial en el diseño y aplicación de sistemas de inteligencia artificial. Estos principios guían a los desarrolladores y a las organizaciones en la creación de tecnologías que respeten y promuevan valores fundamentales.

Transparencia y rendición de cuentas

La transparencia es uno de los principios más importantes en la ética de la inteligencia artificial. Implica que los procesos y algoritmos utilizados en los sistemas de IA deben ser comprensibles y accesibles para todos los usuarios.

La rendición de cuentas se refiere a la obligación de los desarrolladores y organizaciones de asumir responsabilidad por las decisiones automatizadas que se tomen, como pueden ser: explicar el funcionamiento de los algoritmos utilizados, proporcionar información acerca de las fuentes de datos y su gestión y reconocer y abordar errores o sesgos en los sistemas.

Principios éticos fundamentales

Los principios éticos fundamentales son esenciales para guiar la creación de sistemas de inteligencia artificial. Estos incluyen la justicia, la no maleficencia, la beneficencia y la autonomía. Cada uno de estos principios desempeña un papel crucial en el desarrollo de tecnologías responsables y éticas.

Si prestas atención y en función de lo que pidas a inteligencias artificiales como Chat GPT, Midjourney o creación de imágenes de Bing, las respuestas pueden ser solicitudes bloqueadas, porque están creadas para ofrecer contenido libre de cualquier interpretación errónea.

- Justicia: Garantizar que las decisiones tomadas por los sistemas de IA no perpetúen desigualdades ni discriminaciones.

- No maleficencia: Asegurar que las tecnologías no causen daño a individuos o grupos.

- Beneficencia: Trabajar para el bienestar de la sociedad, utilizando la IA para mejorar la calidad de vida.

- Autonomía: Respetar el derecho de las personas a tomar decisiones informadas sobre su utilización de tecnologías de IA.

Valores y principios en la toma de decisiones

La toma de decisiones en sistemas de inteligencia artificial debe estar basada en valores éticos que reflejen la diversidad y la equidad.

Es fundamental considerar las implicaciones sociales de las decisiones tomadas por estos sistemas, garantizando que se alineen con los valores de justicia y respeto por los derechos humanos.

- Promover la inclusión de diversas perspectivas en el proceso de diseño.

- Fomentar la participación de grupos afectados en la toma de decisiones sobre los sistemas de IA.

- Asegurar que la tecnología respete los principios democráticos y éticos en su aplicación.

Marco ético en inteligencia artificial

La creación de un marco ético sólido para la inteligencia artificial es esencial para guiar su desarrollo y uso responsable. Este marco debe incluir normativas claras, lineamientos y principios que sirvan de base para las prácticas de diseño y aplicación de IA.

- Desarrollar códigos de conducta para profesionales del ámbito de IA.

- Incorporar auditorías éticas en el ciclo de vida de desarrollo de sistemas de IA.

- Promover la colaboración entre distintos sectores para establecer estándares éticos comunes.

Prácticas responsables y éticas en el uso y desarrollo de tecnologías de IA

Las prácticas responsables en el uso de tecnologías de inteligencia artificial son fundamentales para asegurar que su desarrollo y aplicación se realicen de manera ética y justa. Estas prácticas deben guiar a las organizaciones en la utilización de la IA en diversos contextos.

El desarrollo de sistemas de inteligencia artificial requiere un enfoque ético que contemple distintas dimensiones. Las prácticas éticas en este ámbito incluyen:

- La consideración de los efectos a largo plazo de las tecnologías en la sociedad.

- La inclusión de diversas voces y perspectivas durante el proceso de diseño y desarrollo.

- La evaluación continua de los modelos de IA a lo largo de su ciclo de vida.

- La implementación de códigos de conducta claros que guíen el comportamiento de los desarrolladores y equipos de trabajo.

Crear un entorno en el que se fomente la ética no solo es responsabilidad de los individuos, sino también de las organizaciones que deben establecer políticas adecuadas.

Buenas prácticas en la gestión de datos

La gestión de datos es un aspecto crítico en el uso de tecnologías de inteligencia artificial. La implementación de buenas prácticas en esta área debe incluir:

- La recolección de datos de manera ética y respetuosa con la privacidad de los individuos.

- El uso de técnicas de anonimización y seudonimización para proteger la información sensible.

- La obtención de consentimientos informados antes de utilizar datos personales.

- La evaluación de la calidad y representatividad de los datos utilizados para entrenar modelos de IA.

Una adecuada gestión de datos es esencial para la creación de sistemas de IA justos y equitativos.

Garantizar prácticas equitativas

Las prácticas equitativas buscan asegurar que la inteligencia artificial beneficie a todos los segmentos de la sociedad. Para garantizar la equidad en el uso de tecnologías de IA, se deben llevar a cabo:

- Evaluaciones de impacto que analicen cómo la tecnología afecta a diferentes grupos demográficos.

- La promoción de la diversidad en los equipos de desarrollo para incorporar diversas perspectivas.

- La implementación de algoritmos que minimicen sesgos y discriminación en las decisiones automatizadas.

- La creación de marcos normativos que protejan a las poblaciones vulnerables de posibles abusos tecnológicos.

Estas acciones permitirán avanzar hacia un uso de la inteligencia artificial que sea justo y equitativo para todas las personas.

Impacto del aprendizaje automático y sus implicaciones

El aprendizaje automático ha revolucionado diversas industrias, pero su uso también conlleva importantes implicaciones éticas que deben ser consideradas con seriedad.

Desde el procesamiento del lenguaje natural hasta las decisiones basadas en datos, el impacto de estas tecnologías es profundo y multidimensional.

Procesamiento del lenguaje natural y ética

El procesamiento del lenguaje natural (PLN) permite a las máquinas entender y generar lenguaje humano. Este avance ha mejorado significativamente la interacción entre humanos y sistemas automatizados, pero plantea cuestiones éticas fundamentales.

- Sesgos en los modelos: Los algoritmos de PLN pueden incorporar sesgos inherentes a los datos con los que son entrenados. Esto puede dar lugar a interpretaciones erróneas y respuestas que perpetúan estereotipos o discriminación.

- Privacidad: La recopilación y análisis de grandes volúmenes de datos lingüísticos pueden afectar la privacidad de los usuarios. La información personal expuesta sin consentimiento plantea serias inquietudes éticas.

- Desinformación: Las herramientas de PLN que generan contenido pueden ser utilizadas para crear desinformación, afectando la confianza pública y socavando la verdad.

Machine learning y sus desafíos éticos

El machine learning, o aprendizaje automático, es la base de muchos desarrollos tecnológicos actuales. Sin embargo, presenta desafíos éticos que requieren atención.

- Transparencia: Muchos algoritmos funcionan como «cajas negras», lo que dificulta entender cómo se toman las decisiones. Esta falta de transparencia puede causar desconfianza en los sistemas automáticos.

- Responsabilidad: Determinar quién es responsable cuando un sistema de aprendizaje automático causa daño es complicado. La atribución de responsabilidad es vital para abordar cualquier problema que surja.

- Desigualdades: Las aplicaciones de machine learning pueden amplificar desigualdades existentes en lugar de mitigarlas. Si los datos de entrenamiento reflejan una sociedad desigual, el resultado será un refuerzo de esos patrones.

Datos utilizados para entrenar modelos

La calidad y la ética de los datos usados en el entrenamiento de modelos de machine learning son cruciales. Aquí se señalan aspectos clave:

- Seleccionar datos representativos: Es fundamental utilizar conjuntos de datos que reflejen adecuadamente a la población en su conjunto para evitar sesgos en el aprendizaje del modelo.

- Consentimiento informado: La recopilación de datos debe basarse en el consentimiento informado de los individuos involucrados, garantizando así que se respeten sus derechos.

- Seguridad de los datos: Proteger la información utilizada para entrenar modelos es esencial para preservar la privacidad y evitar filtraciones que puedan tener consecuencias negativas.

Normativas y estándares internacionales en ética IA

Las normativas y estándares internacionales en ética de la inteligencia artificial son fundamentales para guiar el desarrollo responsable de esta tecnología. Estos marcos buscan establecer directrices que promuevan la equidad, la transparencia y la protección de los derechos humanos en un contexto global.

Aportes de Naciones Unidas

Las Naciones Unidas han desempeñado un papel clave en la regulación de la inteligencia artificial desde sus inicios. La organización ha abordado la necesidad de un enfoque ético en la aplicabilidad de la IA, promoviendo medidas que protejan los derechos de todas las personas. Entre sus iniciativas se encuentran:

- Establecimiento de grupos de trabajo que analizan los impactos de la IA en los derechos humanos.

- Publicación de informes que evalúan cómo las tecnologías emergentes pueden afectar a distintas poblaciones.

- Organización de foros internacionales para debatir sobre las implicaciones éticas de la IA y compartir mejores prácticas.

Directrices de la Unesco

La Unesco, por su parte, ha desarrollado directrices específicas para la inteligencia artificial que subrayan la importancia de la ética en su implementación. Estas directrices se centran en varios puntos importantes:

- Fomento de un enfoque centrado en el ser humano en el diseño y la aplicación de la IA.

- Promoción de la inclusión y la diversidad en el ámbito tecnológico.

- Establecimiento de principios para la educación y la cooperación internacional en IA.

Marco regulatorio a nivel internacional

Existen múltiples esfuerzos para crear un marco regulatorio que aborde los desafíos éticos y legales que presenta la inteligencia artificial. Este marco incluye:

- Normas que buscan diseñar un enfoque uniforme para la gestión de la IA entre diferentes países.

- Iniciativas que abarcan la responsabilidad de las empresas y la protección de los usuarios.

- Mecanismos para la evaluación y certificación de tecnologías de IA, a fin de asegurar su adecuación ética.

Coordinación entre estados miembros

La cooperación entre los estados miembros es esencial para adoptar un enfoque coherente en la regulación de la IA. Se está trabajando en:

- Establecimiento de plataformas intergubernamentales para compartir información y mejores prácticas.

- Desarrollo de políticas comunes que ayuden a enfrentar los retos éticos derivados de la IA.

- Colaboración en la investigación sobre los impactos sociales de la inteligencia artificial y su regulación.

Inteligencia Artificial y WhatsApp

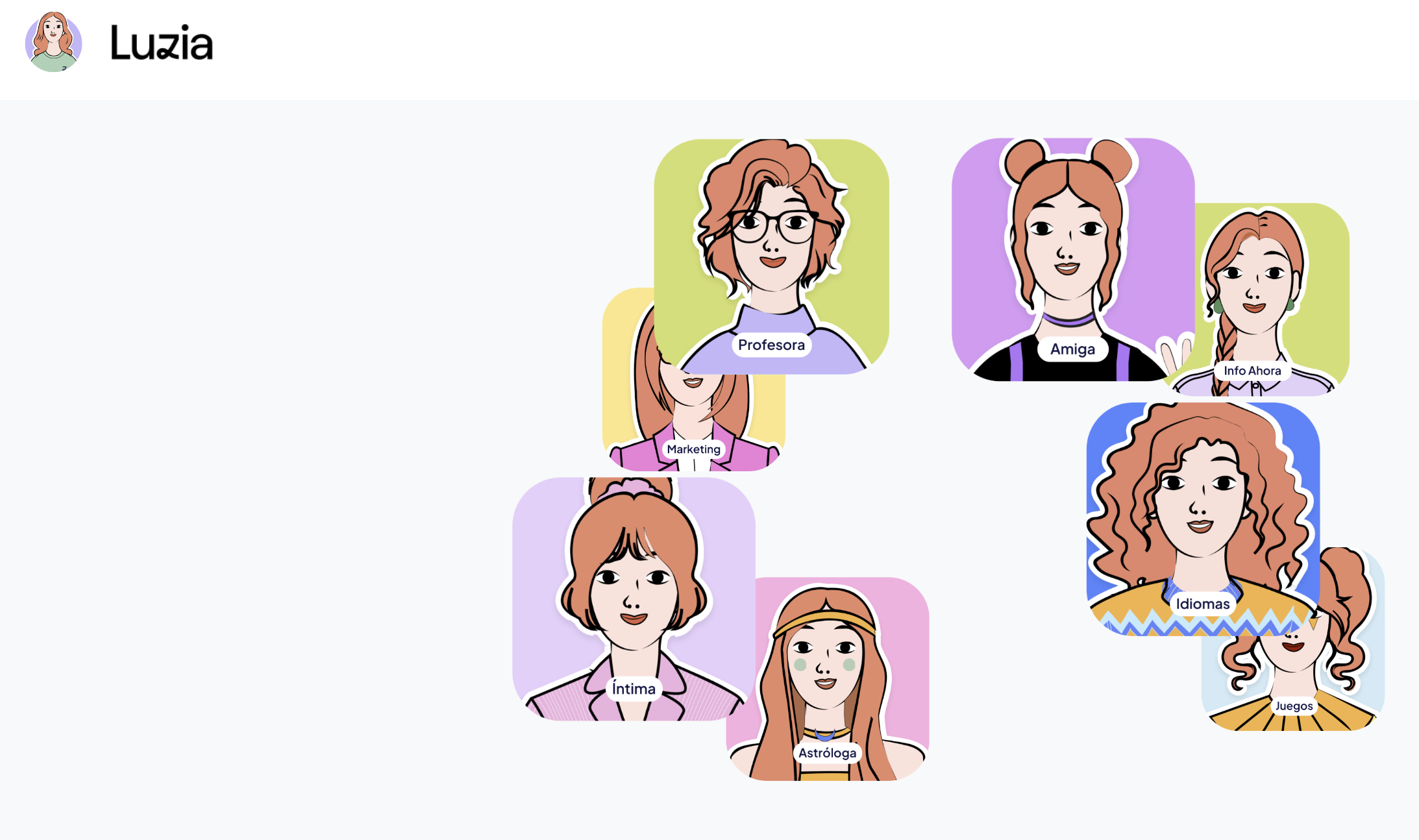

Hace un año descubrimos la web de soyluzia.es, ha cambiado desde entonces, un número de teléfono al que das acceso a tu WhatsApp, y entre muchas otras cosas, le puedes reenviar los audios que tus contactos te envían para que los pase a texto, por ejemplo.

Aquí entra la ética, ¿Qué ocurre si esos mensajes de audio que enviamos a “no sabemos quien” contienen datos privados? ¿Hasta qué punto respetarán la privacidad?

En su web hay un enlace a la política de privacidad en el que informan la finalidad, tratamiento de datos y con quien se comparte, antes de instalar cualquier app en tu móvil, te recomendamos que te leas cuidadosamente la política de privacidad para saber si cumplen o no con la normativa Europea de protección de datos.

Por todo lo anterior, la ética en el desarrollo de sistemas de IA es esencial para garantizar que la tecnología se utilice de manera responsable y beneficie a la sociedad en su conjunto.

La IA puede tener un impacto significativo negativo en las personas, desde la pérdida de empleos hasta la invasión de la privacidad, y es importante que se aborden estos problemas a medida que la tecnología continúa avanzando.

Uno de los mayores problemas éticos en el desarrollo de sistemas de IA es la privacidad, tal y como comentamos al inicio de este artículo, la IA puede recopilar y analizar grandes cantidades de datos, lo que puede incluir información personal y privada de los usuarios.

Es importante que los desarrolladores de IA tengan en cuenta la privacidad de los usuarios y tomen medidas para protegerla. Esto puede incluir técnicas como el cifrado de datos y la limitación del acceso a los datos solo a aquellos que lo necesitan para desarrollar y mejorar el sistema de IA.

Otro problema ético importante en la IA es la discriminación. Los sistemas de IA pueden perpetuar y amplificar las desigualdades existentes en la sociedad, como el sesgo racial y de género.

Los desarrolladores de IA deben asegurarse de que sus sistemas no perpetúen o amplifiquen estas desigualdades y trabajar para garantizar que la tecnología beneficie a todos, independientemente de su raza, género, orientación sexual o cualquier otra característica.

La transparencia también es importante en el desarrollo de sistemas de IA. Los usuarios deben saber cómo se está utilizando la tecnología y qué datos se están recopilando y analizando.

Los desarrolladores de IA deben ser transparentes sobre cómo se está utilizando la tecnología y proporcionar información clara y accesible sobre su funcionamiento.

En cualquier caso, apelamos a la responsabilidad y el sentido común de todos en el uso de esta tecnología que, definitivamente, está cambiando la forma en la que navegamos por Internet, nos comunicamos y trabajamos.

Si buscas un desarrollador para tu web, aplicaciones móviles o videojuegos contáctanos por teléfono al +34 679 44 64 36 o escríbenos a info@qualitydevs.com.

Imagen de portada: Creada con Inteligencia Artificial de Magic Studio